Bronnen emoties: Difference between revisions

No edit summary |

No edit summary |

||

| (3 intermediate revisions by the same user not shown) | |||

| Line 4: | Line 4: | ||

http://citeseerx.ist.psu.edu/viewdoc/summary?doi=10.1.1.52.5802 | http://citeseerx.ist.psu.edu/viewdoc/summary?doi=10.1.1.52.5802 | ||

Het grootse probleem bij het vinden van geschikte bronnen is dat er meestal niet specifiek wordt ingegaan op verschillende emoties. Er worden belangrijke kenmerken genoemd om emoties te onderscheiden. Echter willen wij niet onderzoeken wat de waarde van een kenmerk is. We willen deze al hebben, zodat we het meteen kunnen implementeren in een programma. Ik heb dus veel meer bronnen gelezen, maar hieronder is een selectie van bronnen die van nut kunnen zijn. | Het grootse probleem bij het vinden van geschikte bronnen is dat er meestal niet specifiek wordt ingegaan op verschillende emoties. Er worden belangrijke kenmerken genoemd om emoties te onderscheiden. Echter willen wij niet onderzoeken wat de waarde van een kenmerk is. We willen deze al hebben, zodat we het meteen kunnen implementeren in een programma. Ik heb dus veel meer bronnen gelezen, maar hieronder is een selectie van bronnen die van nut kunnen zijn. | ||

====="Emotional speech recognition: Resources, features, and methods"===== | |||

http://ac.els-cdn.com/S0167639306000422/1-s2.0-S0167639306000422-main.pdf?_tid=25bfc3dc-38e8-11e4-91b2-00000aab0f02&acdnat=1410353224_2da9b149effc4602e231561029ebe38d | http://ac.els-cdn.com/S0167639306000422/1-s2.0-S0167639306000422-main.pdf?_tid=25bfc3dc-38e8-11e4-91b2-00000aab0f02&acdnat=1410353224_2da9b149effc4602e231561029ebe38d | ||

| Line 18: | Line 13: | ||

Summary of the effects of several emotion states on selected acoustic features. The selected features are pitch, intensity and timing. The emotions that are used are anger, disgust, fear, joy anger. There are no values given to the different states, but the author gives indications whether an acoustic feature increases/decreces/etc. with an emotion. | Summary of the effects of several emotion states on selected acoustic features. The selected features are pitch, intensity and timing. The emotions that are used are anger, disgust, fear, joy anger. There are no values given to the different states, but the author gives indications whether an acoustic feature increases/decreces/etc. with an emotion. | ||

====="Emotion Recognition by Speech Signals"===== | |||

http://www.isca-speech.org/archive/eurospeech_2003/e03_0125.html | http://www.isca-speech.org/archive/eurospeech_2003/e03_0125.html | ||

| Line 24: | Line 19: | ||

Seems like an interesting article, but I have no access to the full text. For emotion recognition, the authors selected pitch, log energy, formant, mel-band energies, and mel frequency cepstral coefficients (MFCCs) as the base features, and added velocity/ acceleration of pitch and MFCCs to form feature streams. | Seems like an interesting article, but I have no access to the full text. For emotion recognition, the authors selected pitch, log energy, formant, mel-band energies, and mel frequency cepstral coefficients (MFCCs) as the base features, and added velocity/ acceleration of pitch and MFCCs to form feature streams. | ||

====="Emotions and Speech: Some Acoustical Correlates"===== | |||

http://www.ohio.edu/people/leec1/documents/sociophobia/williams_stevens_1972.pdf | http://www.ohio.edu/people/leec1/documents/sociophobia/williams_stevens_1972.pdf | ||

| Line 30: | Line 25: | ||

For the emotions anger, fear and sorrow some important acoustic features are summed up. These features are compared to a neutral from of speech. Examples of the acoustic features are fundamental frequency and duration of the syllables. Some of the features will be difficult to implement in a computer program. | For the emotions anger, fear and sorrow some important acoustic features are summed up. These features are compared to a neutral from of speech. Examples of the acoustic features are fundamental frequency and duration of the syllables. Some of the features will be difficult to implement in a computer program. | ||

====="Handig artikel"===== | |||

http://www.cvauni.edu.vn/imgupload_dinhkem/file/Chuyen%20De%20HCI/3_%20Analysis%20of%20Emotion%20Recognition%20using%20facial%20expression-speech.pdf | http://www.cvauni.edu.vn/imgupload_dinhkem/file/Chuyen%20De%20HCI/3_%20Analysis%20of%20Emotion%20Recognition%20using%20facial%20expression-speech.pdf | ||

| Line 36: | Line 31: | ||

Dit artikel is een overzicht van verschillende onderzoeken. Het is met name geschikt voor de bronnenlijst. Echter de bronnen die ik er tot nu toe mee heb gevonden zijn niet interessant voor ons onderzoek. | Dit artikel is een overzicht van verschillende onderzoeken. Het is met name geschikt voor de bronnenlijst. Echter de bronnen die ik er tot nu toe mee heb gevonden zijn niet interessant voor ons onderzoek. | ||

====="http://www.fon.hum.uva.nl/praat/"===== | |||

The most widely used speech cues for audio emotion recognition are global-level prosodic features such as the statistics of the pitch and the intensity. Therefore, the means, the standard deviations, the ranges, the maximum values, the minimum values and the medians of the pitch and the energy were computed using Praat speech processing software . In addition, the voiced/speech and unvoiced/speech ratio were also estimated. By the use of sequential backward features selection technique, a 11-dimensional feature vector for each utterance was used as input in the audio emotion recognition system. | |||

====="Prosody and Speaker State: Paralinguistics, Pragmatics, and Proficiency"===== | |||

Jackson J. Liscombe, 2007 | |||

http://citeseerx.ist.psu.edu/viewdoc/download?doi=10.1.1.135.7503&rep=rep1&type=pdf | |||

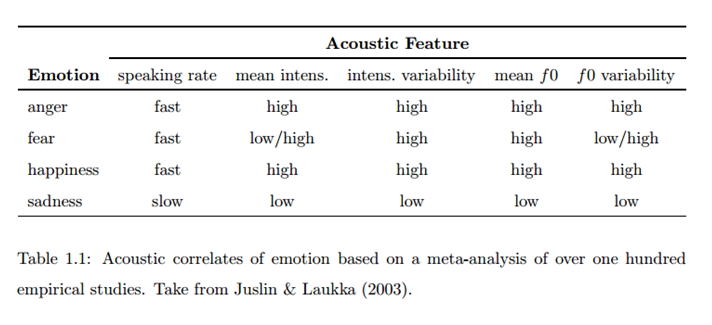

“Juslin & Laukka (2003) composed a meta-analysis of over one hundred studies conducted between 1939 and 2002.” (Liscombe, 2007) De uitkomst van deze meta-analyse is te zien in de tabel hier beneden. Uit al het onderzoek uitgevoerd tussen 1939 en 2002 komen een aantal kenmerken naar voren die specifiek zijn voor de emoties boos, angst, blij en verdrietig. Dit zijn de spreeksnelheid, de gemiddelde intensiteit en de variatie in intensiteit, de gemiddelde fundamentale frequentie en de variatie in deze frequentie. In de tabel is echter ook te zien dat boos en blij dezelfde specifieke kenmerken hebben, dus de vraag is hoe deze twee emoties dan te onderscheiden zijn. Ook angst kan verward worden met boos en blij, afgaande op deze kenmerken. | |||

[[File:Meta analysis acoustic correlates of emotion.png |450px]] | |||

Om deze reden wordt emotie vaak opgedeeld in twee dimensies: activatie en valentie. Bovengenoemde kenmerken vallen onder activatie, en deze kenmerken alleen kunnen dus niet het verschil in boos, blij en verdriet verklaren. Daarvoor zou dus de tweede dimensie kunnen zijn. Er is echter geen overeenstemming tussen onderzoekers over wat deze dimensie bepaalt en of hij uberhaupt wel bestaat. | |||

“Some have suggested that voice quality may play a role (e.g, Scherer et al., 1984; Ladd et al., 1985; Zetterholm, 1999; Tato et al., 2002; Gobl & Chasaide, 2003; Fernandez, 2004; Turk et al., 2005), while others have suggested categorical intonation units (e.g., Uldall, 1964; O’Connor & Arnold, 1973; Scherer et al., 1984; Mozziconacci & Hermes, 1999; Wichmann, 2002; Pollermann, 2002).” (Liscombe, 2007) | |||

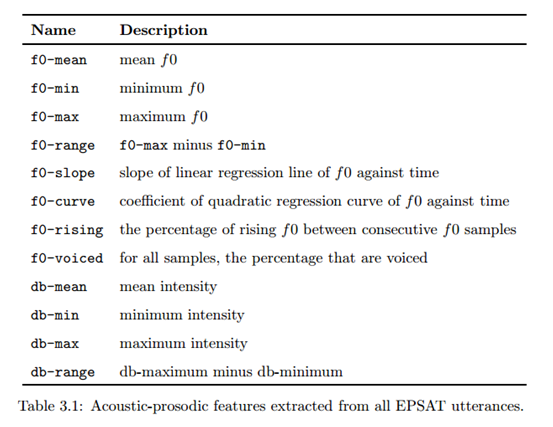

Liscombe (2007) voerde zelf ook een onderzoek uit naar emoties in spraak. Hierbij werden de parameters kenmerkend voor bepaalde emoties verkregen door het programma EPSAT (Emotional Prosody Speech and Transcript corpus). Data van spraak van 8 professionele acteurs werd gebruikt om deze parameters te vinden. De zinnen die gebruikt werden waren neutrale zinnen (dus geen woorden die gelinkt kunnen worden aan emotie) en 4 lettergrepen lang. Er werden 14 emoties en neutrale spraak opgenomen. De parameters die EPSAT genereerde zijn in tabel 3.1 te zien. | |||

[[File:Parameters EPSAT.png |400px]] | |||

De kenmerken die het belangrijkst waren om onderscheid te maken tussen emoties waren: f0-mean, f0-min, f0-rising, db-min, db-range. Uit het onderzoek van Liscombe (2007) bleek dat op basis van deze kenmerken de volgende emoties van elkaar onderscheden konden worden: hot-anger, elation, happy, boredom, panic en neutral. De overige emoties die ze onderzochten konden in drie verschillende groepen van elkaar onderscheden worden, maar binnen die groepen niet. | |||

====="These were synthesised using a formant synthesiser, and the voice source parameter settings were guided by prior analytic studies as well as auditory judgements."===== | |||

Deze zin komt uit: http://www.sciencedirect.com/science/article/pii/S0167639302000821 | Deze zin komt uit: http://www.sciencedirect.com/science/article/pii/S0167639302000821 | ||

Dus wellicht kunnen we een deel van de parameters voor de stem baseren op eerder onderzoek en een deel overlaten aan 'auditory judgements'. | Dus wellicht kunnen we een deel van de parameters voor de stem baseren op eerder onderzoek en een deel overlaten aan 'auditory judgements'. | ||

====="http://web.stanford.edu/dept/HPS/154/Workshop/Role%20of%20Emotion%20in%20Believable%20AgentsBATES.pdf"===== | |||

Dit onderzoek gaat over de rol van emotie in de believability van agents. In de conclusie staat: ''Emotion is one of the primary means to achieve this believability, this illusion of life, because it helps us know that characters really care about what happens in the world, that they truly have desires.'' | Dit onderzoek gaat over de rol van emotie in de believability van agents. In de conclusie staat: ''Emotion is one of the primary means to achieve this believability, this illusion of life, because it helps us know that characters really care about what happens in the world, that they truly have desires.'' | ||

| Line 64: | Line 65: | ||

Ik kom er nog niet helemaal achter of ze nu bewijs hebben dat emotie believability vergroot, of dat dit hier zomaar een aanname is. | Ik kom er nog niet helemaal achter of ze nu bewijs hebben dat emotie believability vergroot, of dat dit hier zomaar een aanname is. | ||

====="http://www.affective-sciences.org/system/files/biblio/1984_Scherer_JASA.pdf"===== | |||

--> BELANGRIJK ARTIKEL! | |||

Dit onderzoek komt ongeveer overeen met wat wij willen gaan doen. | Dit onderzoek komt ongeveer overeen met wat wij willen gaan doen. | ||

| Line 71: | Line 72: | ||

Wat er o.a. gevonden is, is dat intonational categories alleen maar affect overdragen wanneer deze gecombineerd worden met grammaticale eigenschappen. | Wat er o.a. gevonden is, is dat intonational categories alleen maar affect overdragen wanneer deze gecombineerd worden met grammaticale eigenschappen. | ||

====="http://scitation.aip.org/docserver/fulltext/asa/journal/jasa/93/2/1.405558.pdf?expires=1410524858&id=id&accname=2115293&checksum=7027346B3B61D918FCF324B061FCBCA5"===== | |||

Op p. 1104 wordt er per onderzochte emotie uitgelegd welke parameters van belang zijn. Ook worden er verschillende waardes gegeven. | Op p. 1104 wordt er per onderzochte emotie uitgelegd welke parameters van belang zijn. Ook worden er verschillende waardes gegeven. | ||

Latest revision as of 14:31, 16 October 2014

Terug: Week 2

http://citeseerx.ist.psu.edu/viewdoc/summary?doi=10.1.1.52.5802

Het grootse probleem bij het vinden van geschikte bronnen is dat er meestal niet specifiek wordt ingegaan op verschillende emoties. Er worden belangrijke kenmerken genoemd om emoties te onderscheiden. Echter willen wij niet onderzoeken wat de waarde van een kenmerk is. We willen deze al hebben, zodat we het meteen kunnen implementeren in een programma. Ik heb dus veel meer bronnen gelezen, maar hieronder is een selectie van bronnen die van nut kunnen zijn.

"Emotional speech recognition: Resources, features, and methods"

Summary of the effects of several emotion states on selected acoustic features. The selected features are pitch, intensity and timing. The emotions that are used are anger, disgust, fear, joy anger. There are no values given to the different states, but the author gives indications whether an acoustic feature increases/decreces/etc. with an emotion.

"Emotion Recognition by Speech Signals"

http://www.isca-speech.org/archive/eurospeech_2003/e03_0125.html

Seems like an interesting article, but I have no access to the full text. For emotion recognition, the authors selected pitch, log energy, formant, mel-band energies, and mel frequency cepstral coefficients (MFCCs) as the base features, and added velocity/ acceleration of pitch and MFCCs to form feature streams.

"Emotions and Speech: Some Acoustical Correlates"

http://www.ohio.edu/people/leec1/documents/sociophobia/williams_stevens_1972.pdf

For the emotions anger, fear and sorrow some important acoustic features are summed up. These features are compared to a neutral from of speech. Examples of the acoustic features are fundamental frequency and duration of the syllables. Some of the features will be difficult to implement in a computer program.

"Handig artikel"

Dit artikel is een overzicht van verschillende onderzoeken. Het is met name geschikt voor de bronnenlijst. Echter de bronnen die ik er tot nu toe mee heb gevonden zijn niet interessant voor ons onderzoek.

"http://www.fon.hum.uva.nl/praat/"

The most widely used speech cues for audio emotion recognition are global-level prosodic features such as the statistics of the pitch and the intensity. Therefore, the means, the standard deviations, the ranges, the maximum values, the minimum values and the medians of the pitch and the energy were computed using Praat speech processing software . In addition, the voiced/speech and unvoiced/speech ratio were also estimated. By the use of sequential backward features selection technique, a 11-dimensional feature vector for each utterance was used as input in the audio emotion recognition system.

"Prosody and Speaker State: Paralinguistics, Pragmatics, and Proficiency"

Jackson J. Liscombe, 2007

http://citeseerx.ist.psu.edu/viewdoc/download?doi=10.1.1.135.7503&rep=rep1&type=pdf

“Juslin & Laukka (2003) composed a meta-analysis of over one hundred studies conducted between 1939 and 2002.” (Liscombe, 2007) De uitkomst van deze meta-analyse is te zien in de tabel hier beneden. Uit al het onderzoek uitgevoerd tussen 1939 en 2002 komen een aantal kenmerken naar voren die specifiek zijn voor de emoties boos, angst, blij en verdrietig. Dit zijn de spreeksnelheid, de gemiddelde intensiteit en de variatie in intensiteit, de gemiddelde fundamentale frequentie en de variatie in deze frequentie. In de tabel is echter ook te zien dat boos en blij dezelfde specifieke kenmerken hebben, dus de vraag is hoe deze twee emoties dan te onderscheiden zijn. Ook angst kan verward worden met boos en blij, afgaande op deze kenmerken.

Om deze reden wordt emotie vaak opgedeeld in twee dimensies: activatie en valentie. Bovengenoemde kenmerken vallen onder activatie, en deze kenmerken alleen kunnen dus niet het verschil in boos, blij en verdriet verklaren. Daarvoor zou dus de tweede dimensie kunnen zijn. Er is echter geen overeenstemming tussen onderzoekers over wat deze dimensie bepaalt en of hij uberhaupt wel bestaat. “Some have suggested that voice quality may play a role (e.g, Scherer et al., 1984; Ladd et al., 1985; Zetterholm, 1999; Tato et al., 2002; Gobl & Chasaide, 2003; Fernandez, 2004; Turk et al., 2005), while others have suggested categorical intonation units (e.g., Uldall, 1964; O’Connor & Arnold, 1973; Scherer et al., 1984; Mozziconacci & Hermes, 1999; Wichmann, 2002; Pollermann, 2002).” (Liscombe, 2007)

Liscombe (2007) voerde zelf ook een onderzoek uit naar emoties in spraak. Hierbij werden de parameters kenmerkend voor bepaalde emoties verkregen door het programma EPSAT (Emotional Prosody Speech and Transcript corpus). Data van spraak van 8 professionele acteurs werd gebruikt om deze parameters te vinden. De zinnen die gebruikt werden waren neutrale zinnen (dus geen woorden die gelinkt kunnen worden aan emotie) en 4 lettergrepen lang. Er werden 14 emoties en neutrale spraak opgenomen. De parameters die EPSAT genereerde zijn in tabel 3.1 te zien.

De kenmerken die het belangrijkst waren om onderscheid te maken tussen emoties waren: f0-mean, f0-min, f0-rising, db-min, db-range. Uit het onderzoek van Liscombe (2007) bleek dat op basis van deze kenmerken de volgende emoties van elkaar onderscheden konden worden: hot-anger, elation, happy, boredom, panic en neutral. De overige emoties die ze onderzochten konden in drie verschillende groepen van elkaar onderscheden worden, maar binnen die groepen niet.

"These were synthesised using a formant synthesiser, and the voice source parameter settings were guided by prior analytic studies as well as auditory judgements."

Deze zin komt uit: http://www.sciencedirect.com/science/article/pii/S0167639302000821 Dus wellicht kunnen we een deel van de parameters voor de stem baseren op eerder onderzoek en een deel overlaten aan 'auditory judgements'.

"http://web.stanford.edu/dept/HPS/154/Workshop/Role%20of%20Emotion%20in%20Believable%20AgentsBATES.pdf"

Dit onderzoek gaat over de rol van emotie in de believability van agents. In de conclusie staat: Emotion is one of the primary means to achieve this believability, this illusion of life, because it helps us know that characters really care about what happens in the world, that they truly have desires.

Ik kom er nog niet helemaal achter of ze nu bewijs hebben dat emotie believability vergroot, of dat dit hier zomaar een aanname is.

"http://www.affective-sciences.org/system/files/biblio/1984_Scherer_JASA.pdf"

--> BELANGRIJK ARTIKEL!

Dit onderzoek komt ongeveer overeen met wat wij willen gaan doen.

Wat er o.a. gevonden is, is dat intonational categories alleen maar affect overdragen wanneer deze gecombineerd worden met grammaticale eigenschappen.

"http://scitation.aip.org/docserver/fulltext/asa/journal/jasa/93/2/1.405558.pdf?expires=1410524858&id=id&accname=2115293&checksum=7027346B3B61D918FCF324B061FCBCA5"

Op p. 1104 wordt er per onderzochte emotie uitgelegd welke parameters van belang zijn. Ook worden er verschillende waardes gegeven.